내년 2분기 출하 예정

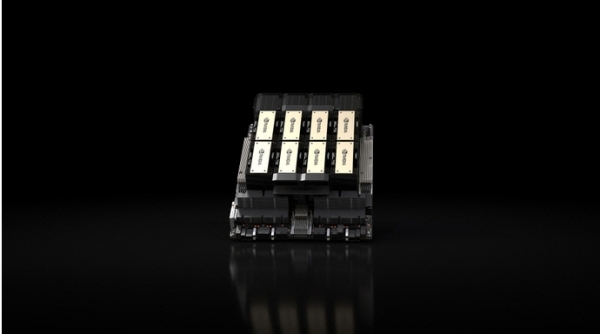

13일(현지시간) CNBC에 따르면 엔비디아는 대규모언어모델(LLM)을 훈련하도록 설계된 최신 그래픽처리장치(GPU) H200을 공개했다. H200은 챗GPT 개발사 오픈AI가 자사의 최신 LLM인 GPT-4 훈련에 사용하는 칩 H100의 업그레이드 버전이다.

H200에는 141기가바이트(GB)의 차세대 메모리 ‘HBM3’가 탑재됐다. HBM(고대역폭메모리)은 데이터 전송 속도를 높여 고성능을 발휘하는 메모리로, 텍스트와 이미지 등을 생성하기 위해 훈련된 LLM의 추론에 도움이 된다.

엔비디아는 “HBM3을 사용하면 H200은 A100에 비해 용량은 약 2배 늘어나고 대역폭은 2.4배 증가한 초당 4.8테라바이트(TB)가 될 것”이라고 설명했다. 또 메타의 LLM 라마2에 H200을 사용한 테스트를 근거로 “H200의 출력이 H100보다 약 2배 빠르다”고 강조했다.

미국 투자은행 레이몬드제임스 추정에 따르면 현재 H100 칩 가격은 2만5000~4만 달러(약 3300만~ 5290만 원)다. LLM을 훈련하는 과정에는 수천 개의 칩이 필요하다. H200의 가격은 아직 알려지지 않았다.

엔비디아는 내년 2분기 H200 출하를 시작할 예정이다.

이안 벅 엔비디아 하이퍼스케일·HPC담당 부사장은 “대용량의 데이터를 고속으로 효율적으로 처리하기 위해 크고 빠른 GPU 메모리를 사용해야 한다”면서 “엔비디아의 H200을 통해 세계에서 가장 중요한 과제 중 일부를 해결하는 속도가 더 빨라질 것”이라고 말했다.

!['수조원'로 쏟았는데…AI 빅테크, 미생ㆍ완생 딜레마 [AI, 거품론 vs 수익화]](https://img.etoday.co.kr/crop/140/88/2061034.jpg)

![에스파→염정아 이어 임영웅까지…이들이 '촌스러움'을 즐기는 이유 [이슈크래커]](https://img.etoday.co.kr/crop/140/88/2061511.jpg)

![중고거래 판매자·구매자 모두 "안전결제 필요" [데이터클립]](https://img.etoday.co.kr/crop/140/88/2061487.jpg)

![법조계 판도 흔드는 ‘AI’…美선 변호사 월급 좌지우지 [로펌, AI에 미래 걸다 ②]](https://img.etoday.co.kr/crop/140/88/2061026.jpg)

![배드민턴협회장, 선수단과 따로 귀국…대표팀 감독은 '침묵' [파리올림픽]](https://img.etoday.co.kr/crop/140/88/2061186.jpg)

![[아시아증시] BOJ '비둘기파 발언'에 시장 안정감 되찾아…중국 7월 수입 급증도 영향](https://img.etoday.co.kr/crop/85/60/2061496.jpg)

![고금리에 카드빚 사상 최대…Z세대, 인플레 충격에 가장 취약 [경고등 켜진 미국 소비]](https://img.etoday.co.kr/crop/85/60/2061525.jpg)

![미국서 ‘가치 추구형’ 소비 대세...기업은 울며 겨자 먹기로 ‘가격 인하 전쟁’ 중 [경고등 켜진 미국 소비]](https://img.etoday.co.kr/crop/85/60/2061440.jpg)

![[안 되는 이유] 약도 안 듣는 여름 감기?…냉방병과 가장 큰 차이는 '이것'](https://img.etoday.co.kr/crop/300/170/2061591.jpg)

![파리올림픽 참관 마친 후 귀국하는 정의선 회장 [포토]](https://img.etoday.co.kr/crop/300/190/2061581.jpg)